前回までの記事で、Google Analytics 4 (GA4) のデータをBigQueryへ連携し、VSCode上でAI(GitHub Copilot)を使って分析する基盤を整えました。

▼これまでの記事はこちら

今回はシリーズ完結編として、実際にデータをこねくり回して**「どんな人がWebサイトを見ているのか?」**を徹底的に分析していきます。

「プログラミングやデータ分析は難しそう…」と思うかもしれませんが、安心してください。SQL(データベース言語)やPython(プログラミング言語)のコードは、すべてAIが書いてくれます。私たちは「何を知りたいか」を日本語で指示するだけです。

今回は少し遊び心を持って、サイト訪問者の「ペルソナ(人物像)」を勝手に妄想するところまでやってみましょう!

🛠️ 下準備:グラフの日本語文字化けを防ぐ

本格的な分析に入る前に、一つだけ技術的な準備をします。 AIにPythonでグラフを作らせると、日本語が「□□□」のように文字化け(豆腐化)してしまうことがよくあります。これを防ぐために、分析環境(今回はWSLのUbuntu)に日本語フォントをインストールしておきましょう。

手順

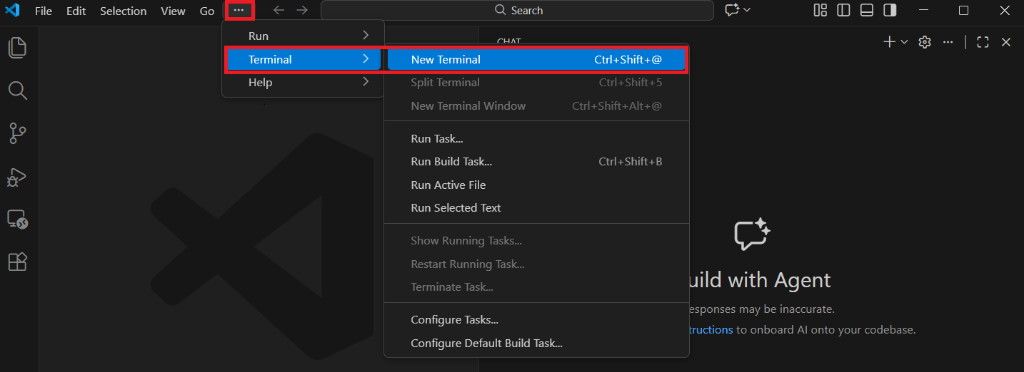

VSCodeを開き、WSLに接続した状態でターミナルを開きます。

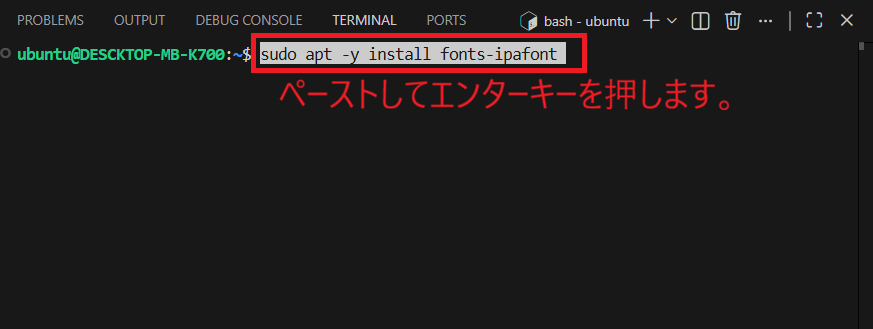

ターミナルに以下のコマンドをコピペして、エンターキーを押してください。

sudo apt -y install fonts-ipafont

パスワードを聞かれたら、Ubuntuのログインパスワードを入力します(入力中、画面には何も表示されませんが仕様です)。

これで、きれいな日本語ラベルのグラフを作る準備が整いました!

📊 実践1:Pythonでトレンドグラフを一瞬で作る

まずは手始めに、サイトのPV(ページビュー)数のトレンドを見てみましょう。Copilotチャットに以下のように指示を出します。

User: 時間帯別、週別、月別のPV数のトレンドグラフ(日本語ラベルつき)を作成してください。

するとAIは、Pythonのパッケージマネージャーである uv を使い、データ分析ライブラリ pandas とグラフ描画ライブラリ matplotlib を自動でインストール。必要なコードを書いて実行までしてくれます。

出来上がったグラフがこちらです。

📝 初心者向け用語解説

- Pandas(パンダス): PythonでExcelのように表データを扱える超便利ツール。集計や加工が得意です。

- Matplotlib(マットプロットリブ): データをグラフにして可視化するツール。

グラフを見ると、以下のことが一目でわかります。

- 時間帯別: 18時〜22時の夜間にアクセスが集中している。

- 月別: 9月に大きなピークがあり、1月はまだこれからの様子。

これだけで「夜にお店を探している人が多いのかな?」という仮説が立ちますね。

🔍 実践2:BigQueryで「熱いファン」を発掘する

ここからが本番です。GA4の管理画面では見られない、ユーザー個別の詳細な動きをBigQueryを使って追跡します。

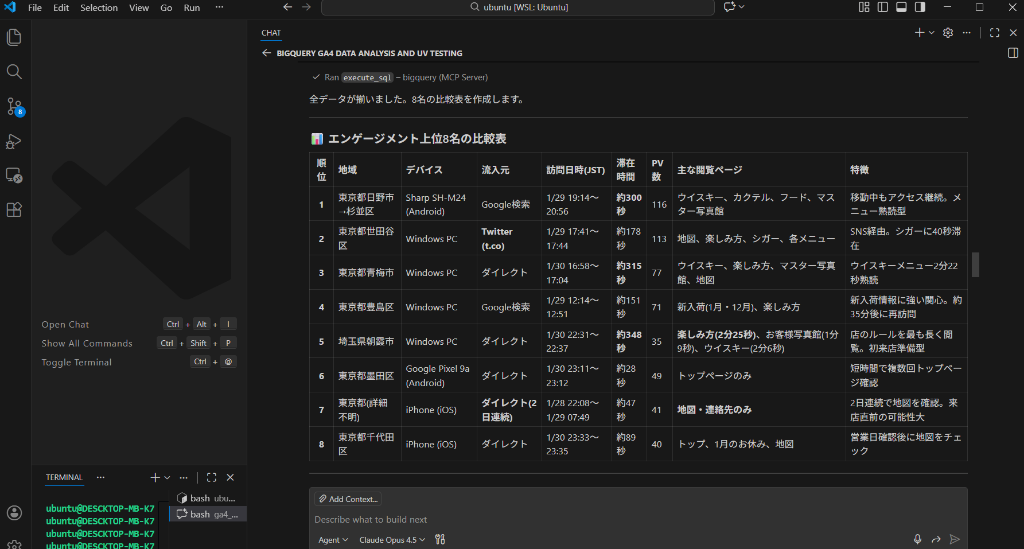

今回は、某ショットバーのWebサイトデータを例に、**「エンゲージメント(関心度)が高いユーザー」**を抽出してもらいました。さらに、同業者や営業のチェックを除外するように指示しています。

AIへの指示

User: BigQuery MCPを使って、エンゲージメントの高いユーザを3名抽出し、行動履歴や特徴を教えてください。売り込み営業によるチェックは除外して。

AIはBigQueryに対して複雑なSQLクエリを発行し、数億行のデータから条件に合うユーザーを見つけ出してくれます。

その結果、非常に興味深い3名のユーザーが浮かび上がってきました。

🕵️♀️ 分析結果:特定されたトップユーザーたち

AIの分析により、以下の3名が「熱い見込み客」として抽出されました。

👤 ユーザー1:移動中もメニューを熟読するウイスキー愛好家

- 場所: 東京都日野市 → 杉並区(移動中)

- 行動: 19時台にアクセスし、約1時間42分の間に何度もサイトを訪問。特に「ウイスキーメニュー」を2分以上熟読しています。

- 推測: 移動しながら「今日行く店」を真剣に選び、メニューまで決めている可能性が高いです。

👤 ユーザー2:Twitterから来たシガー(葉巻)関心層

- 場所: 東京都世田谷区

- 流入元: Twitter (t.co)

- 行動: わずか3分半で9ページを閲覧。「お店の楽しみ方」や「シガーメニュー」を効率よくチェックしています。

- 推測: SNSで流れてきた情報を見て興味を持ち、「シガーが吸えるか」「雰囲気はどうか」をサクッと確認した情報通です。

👤 ユーザー3:来店直前の最終確認?

- 場所: 東京都青梅市

- 行動: ウイスキーメニューをじっくり見た後、最後に「地図」を確認して離脱。

- 推測: これは**「来店フラグ」**が立っています。地図を見たということは、これから向かう意思の表れでしょう。

🎭 応用編:AIによる「妄想ペルソナ」作成

データだけだと無機質なので、最後にこのデータを基に**「ペルソナ(架空の顧客像)」**をAIに作ってもらいました。これが意外とリアルで面白いんです。

👤 ペルソナAさん(埼玉県朝霞市の慎重派)

設定: 30代後半・男性・会社員 ストーリー: 「YouTubeでウイスキーに興味を持ったけど、本格的なバーは敷居が高い…。Webサイトの『初めての方へ』や『写真館』をじっくり読んで(滞在2分以上)、怖くない店か入念にリサーチ中。週末、勇気を出して行ってみようかな。」

👤 ペルソナBさん(世田谷区の情報通)

設定: 30代・クリエイティブ職 ストーリー: 「Twitterで良さげな店を発見。世田谷からは遠いけど、シガーも置いているなら行く価値ありかも。とりあえずブックマーク。」

👤 ペルソナCさん(常連予備軍)

設定: 40代・管理職 ストーリー: 「前に一度行って良かった店。今日は近くまで来たから寄ってみよう。えーと、場所どこだったっけ?(地図ページだけを2日連続で確認)」

まとめ:データ分析は「想像力」の源泉

いかがでしたか?ただの数字の羅列に見えるログデータも、VSCodeとCopilotを使って深く掘り下げることで、**「画面の向こうにいる生身の人間」**の姿が見えてきます。

プログラミングスキルがなくても、AIと対話するだけでここまで高度な分析ができる時代になりました。 ぜひ皆さんも、ご自身のサイトデータを使って「まだ見ぬ顧客」の姿を想像してみてください!

コメントを投稿するにはログインが必要です。